| Seit 03/2018 | Professor an der FH Münster | |

| Seit 12/2020 | Vorstand Institut für Prozessmanagement und Digitale Transformation (IPD) | |

| Seit 03/2022 | Studiengangsleiter Master "Digital Business and Innovation Management" | |

| Seit 01/2020 | Co-Founder TradeLink | |

| Seit 01/2019 | Co-Founder ScaleWork | |

| 05/2011 - 02/2018 | Expert und Engagement Manager, McKinsey & Company, Inc. | |

| 04/2011 | Promotion in Statistik, TU Dortmund | |

| 06/2008 | Diplom in Statistik, TU Dortmund |

(X)AI Potentiale

Navigate, 12. März 2024

Vorstellung

Kurzvorstellung

Prof. Dr. Michael Bücker

Professor für Data Science, Mathematik und Wirtschaftsinformatik

Büro: Raum C 521

Telefon: 0251 83-65615

E-Mail: michael.buecker@fh-muenster.de

www.buecker.ms

1 Einführung in Explainable AI

1.1 Künstliche Intelligenz (KI) / Artificial Intelligence (AI)

1.2 Künstliche Intelligenz (KI) / Artificial Intelligence (AI)

- Künstliche Intelligenz (KI) bezieht sich auf Systeme oder Maschinen, die menschenähnliche Fähigkeiten wie Lernen, Verstehen und Entscheidungsfindung zeigen

- KI-Systeme nutzen Algorithmen und große Datenmengen, um Muster zu erkennen und Entscheidungen zu treffen; sie basieren auf maschinellem Lernen (ML), häufig Deep Learning (DL)

- Zentrales Merkmal: Black Box-Natur, d.h. die genaue Art und Weise, wie sie zu Entscheidungen oder Vorhersagen kommen, ist oft nicht transparent oder nachvollziehbar

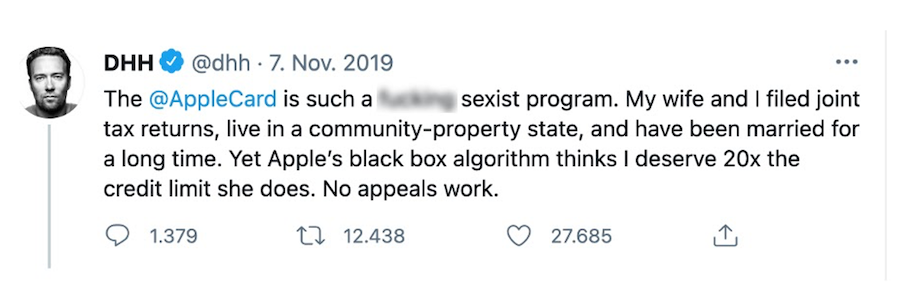

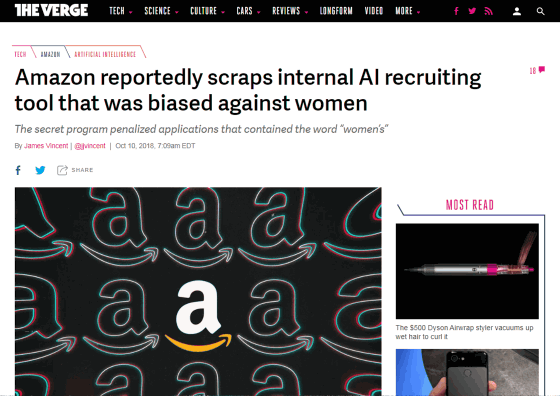

1.3 Probleme durch “Black Box KI” - Beispiele

KI-Systeme können bestehende gesellschaftliche Vorurteile widerspiegeln oder verstärken, wenn sie auf verzerrten Daten trainiert werden:

- Apple Card: Frauen erhielten systematisch niedrigere Kreditlimits als Männer, unabhängig von vergleichbarer Kreditwürdigkeit.

- Amazon Rekrutierung: Ein KI-Tool bevorzugte männliche Bewerber, da es auf historischen Einstellungsdaten trainiert wurde, die eine Männerdominanz aufwiesen.

- COMPAS Rückfallrisiko-Bewertung: Ein KI-System zur Bewertung des Rückfallrisikos von Straftätern stuft afroamerikanische Angeklagte fälschlicherweise als höheres Risiko ein als weiße Angeklagte.

- Gesichtserkennungstechnologien: Gesichtserkennungssysteme sind bei hellhäutigen Männern genauer also bei Frauen und Personen mit dunklerer Hautfarbe.

1.4 Explainable AI (XAI)

Definition

XAI (Erklärbare KI) zielt darauf ab, die Arbeitsweise und Entscheidungen von KI-Systemen transparent und verständlich für den Menschen zu machen.

Ziele

- Transparenz: Gewährleistung, dass Funktionsweise und Entscheidungsfindung nachvollziehbar ist.

- Vertrauen: Aufbau von Vertrauen durch klare Erklärungen der KI-Entscheidungen.

- Verantwortlichkeit: Zuweisung von Verantwortung für Entscheidungen, die von KI-Systemen getroffen werden.

- Förderung der Akzeptanz: Erhöhung der Akzeptanz von KI-Systemen in der Gesellschaft.

- Ethische KI-Entwicklung: Entwicklung von KI-Systemen, die die menschlichen Werte und Rechte achten.

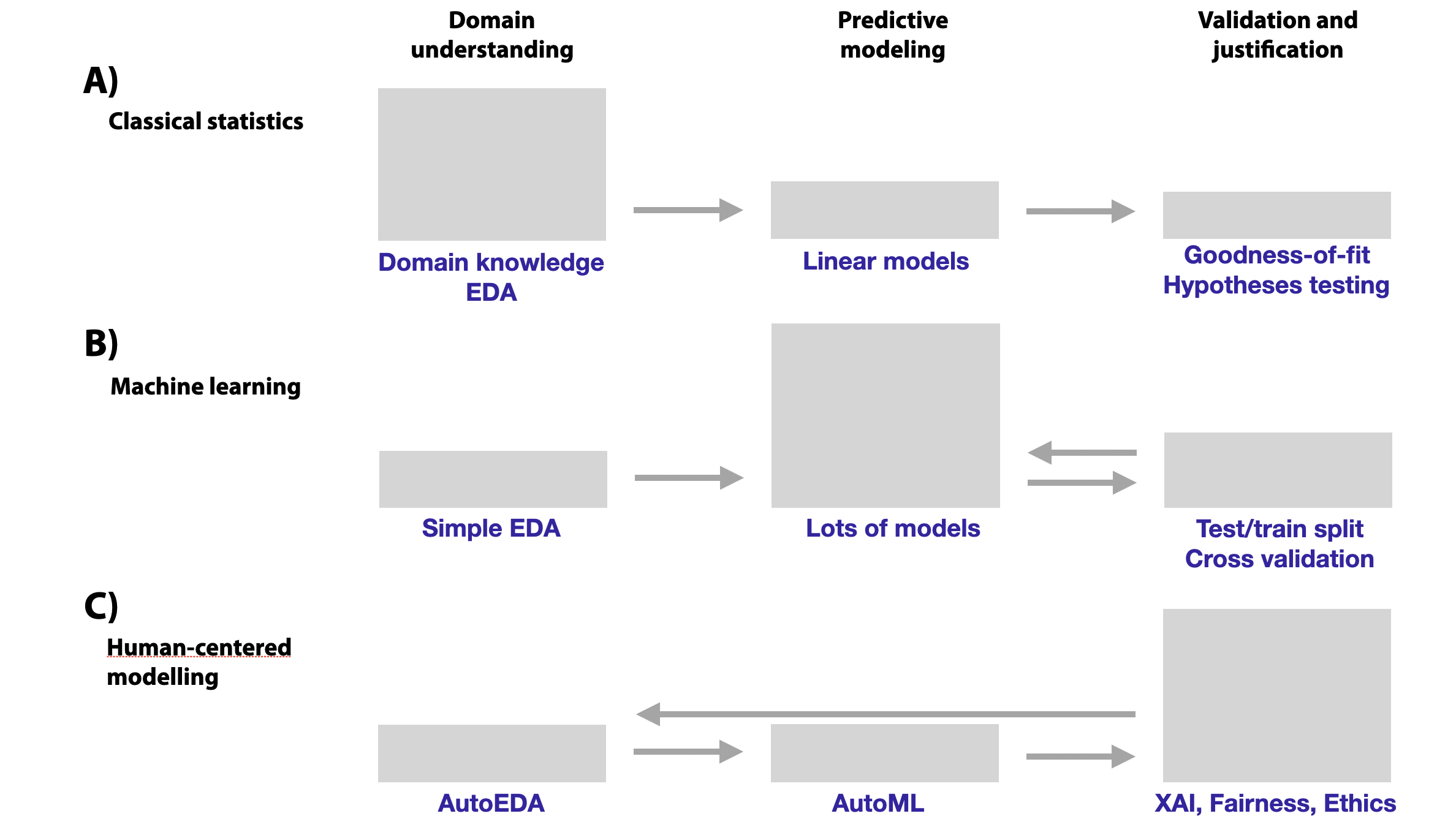

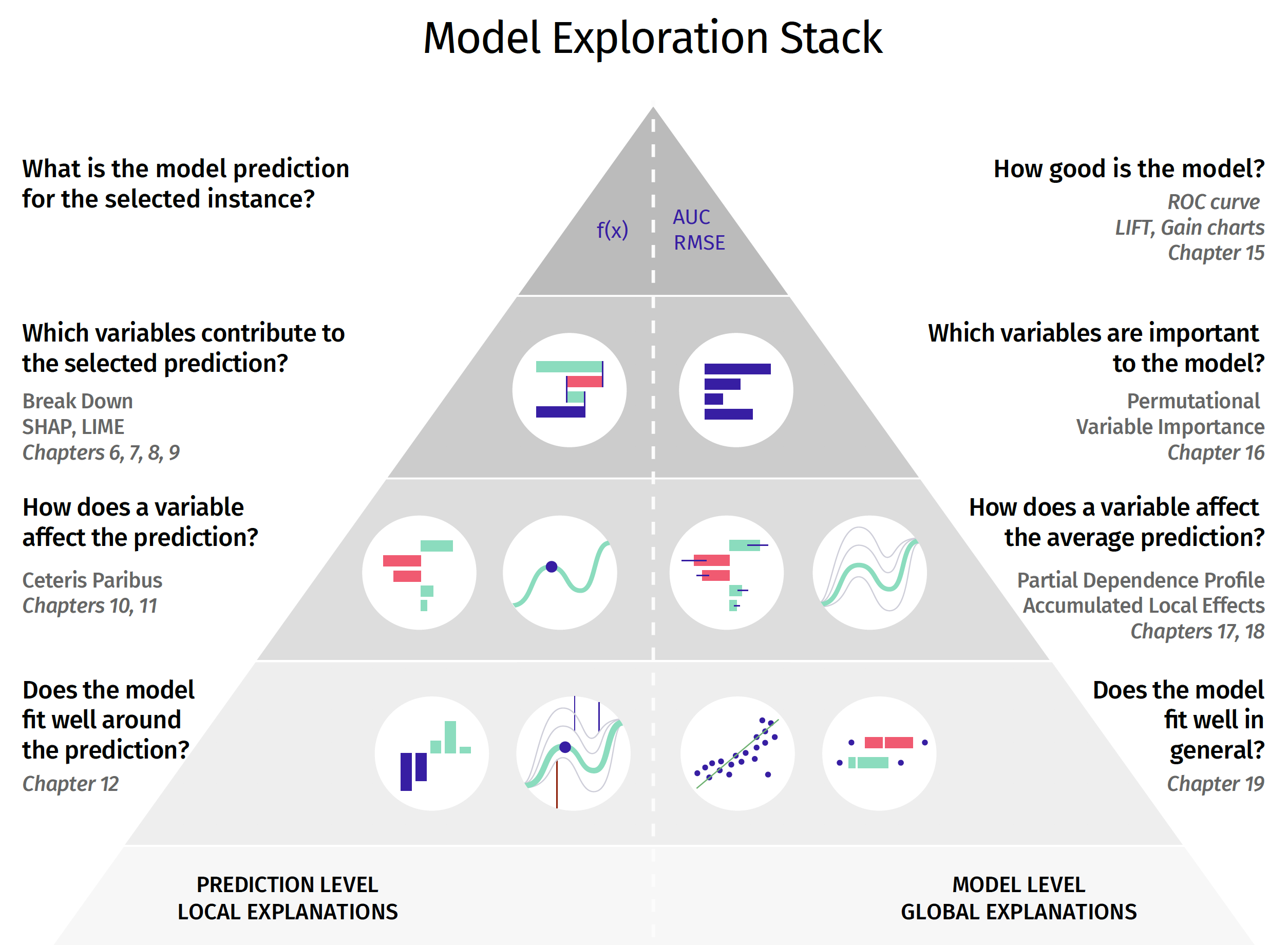

1.5 XAI Methoden

- Für einfache Machine Learning Modelle (lineare/additive Modelle, Random-Forests, neuronale Netze) existieren spezifische Techniken zur Modellerklärung

- Es existieren auch zahlreiche modell-agnostische Ansätze die keine Annahmen über die Modellstruktur machen

- Es können sowohl globale Aussagen über die Funktionsweise eines Modells gemacht werden als auch auch einzelne Vorhersagen interpretiert werden

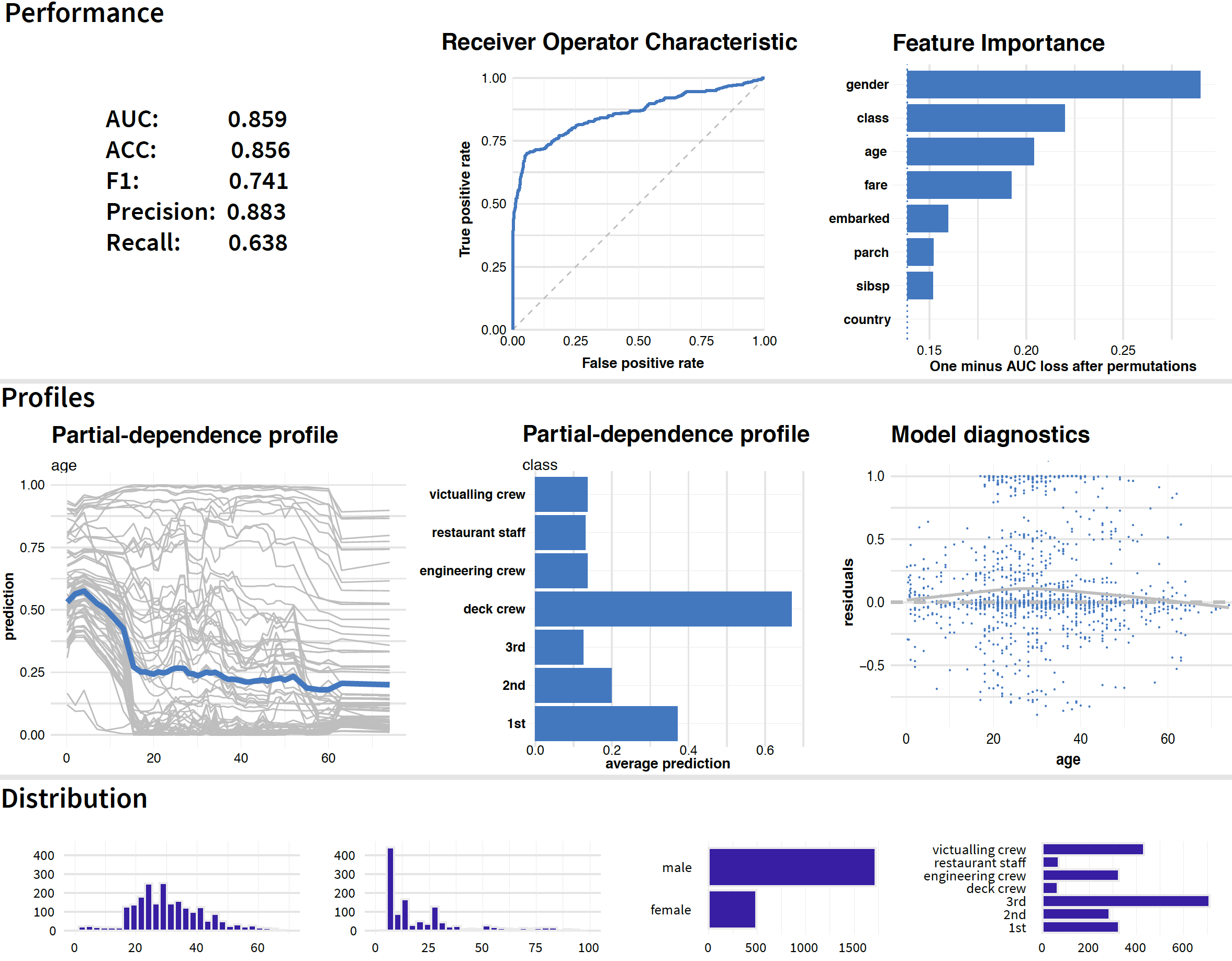

1.6 Beispiel für Ergebnisse von XAI

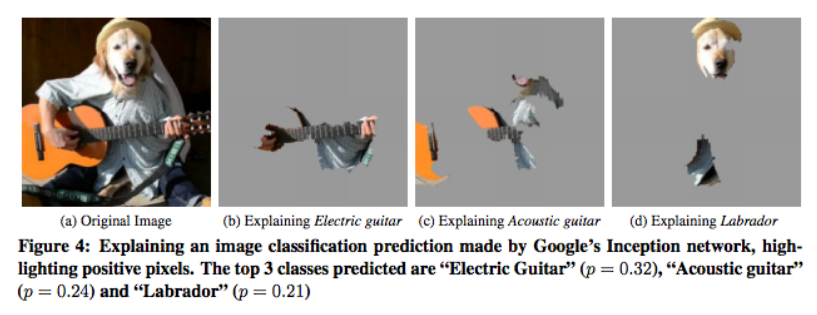

1.7 XAI Beispiel für Bilderkennung

Abbildung 5: XAI (konkret Lime) am Beispiel von Bilderkennung, Quelle: Ribeiro, Singh, und Guestrin (2016)

2 Die EU KI Verordnung und ihre Bedeutung für XAI

2.1 Die EU KI-Verordnung

- Zielsetzung: Schaffung eines Rahmens für die sichere Entwicklung, Einführung und Nutzung künstlicher Intelligenz (KI) in der EU

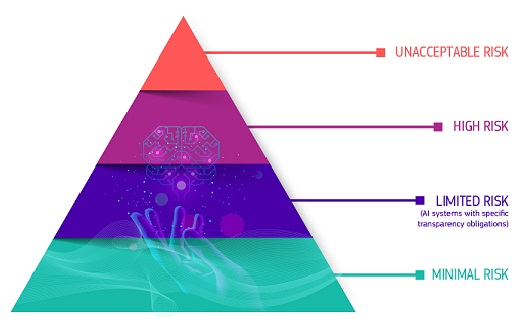

- Risikobasierter Ansatz: Einteilung von KI-Systemen in vier Risikokategorien (unannehmbar, hoch, begrenzt, minimal) mit entsprechenden Regulierungsanforderungen.

- Transparenzpflichten: Vorschriften für bestimmte KI-Systeme, wie Chatbots, die Nutzer darüber informieren müssen, dass sie mit einer KI interagieren.

- Datenschutz und Datenqualitätsmanagement: Anforderungen an die Daten, die zur Entwicklung von KI-Systemen verwendet werden, um Risiken der Diskriminierung zu minimieren.

- Überwachung und Compliance: Einrichtung von Mechanismen zur Überwachung der Einhaltung der Vorschriften und für Sanktionen bei Verstößen.

2.2 Anforderungen an Hochrisiko Systeme

Was sind Hochrisiko Systeme?

- Kritische Infrastruktur

- Bildungs- oder Berufsausbildung

- Sicherheitskomponenten von Produkten

- HR

- Strafverfolgung

- Justiz

- private und öffentliche Dienstleistungen

Anforderungen der EU

- Entwickler von Hochrisiko-KI müssen Risikomanagement, Datenverwaltung und Transparenz sicherstellen und ihre Systeme in einer EU-Datenbank registrieren.

- Sie bestimmen die Risikokategorie ihres Systems selbst und können Konformität eigenständig zertifizieren.

- Verstöße ziehen hohe Geldstrafen nach sich: Nichteinhaltung kann mit 20 Millionen Euro oder 4% des weltweiten Umsatzes geahndet werden.

- Betreiber müssen Überwachung und Dokumentation gewährleisten.

2.3 Wichtige Aspekte für die Umsetzung der KI-Verordnung

- Branchenübergreifende Betroffenheit: KI-Regulierungen betreffen alle Branchen und Unternehmensgrößen.

- Allgemeine Unternehmensauswirkungen: Implementierungskosten, Rechtsunsicherheiten.

- Prozessanpassungen: Erfordern “Compliance by Design” und Risikobetrachtung.

- Strukturelle Anpassungen: Integration von Compliance, möglicherweise durch neue Rollen wie KI-Beauftragte.

- Vorteile vs. Nachteile: Transparenz und Sicherheit vs. Einschränkungen und Innovationshemmung.

Abbildung 7: Handlungsfelder für Unternehmen zur Umsetzung der KI VO (vgl. Dahm und Twesten 2023, 48)

3 XAI in der Praxis: Herausforderungen und Chancen

3.1 Herausforderungen

- Komplexität: Erklärungen können zu komplex für Nicht-Experten sein.

- Standardisierung: Fehlende Standards erschweren die Bewertung der Qualität von Erklärungen.

- Leistungseinbußen: XAI kann die Leistung von KI-Modellen beeinträchtigen, insbesondere in zeitkritischen Anwendungen.

- Vertrauen vs. Verständlichkeit: Schwierigkeiten beim Erreichen des richtigen Gleichgewichts zwischen Genauigkeit und Verständlichkeit der Erklärungen.

- Datenschutz und Sicherheit: Erklärungen können sensible Informationen preisgeben oder Sicherheitsrisiken bergen.

- Perspektive: Einsatz von XAI-Methoden hängt stark von der Perspektive des Stakeholders ab (siehe Abbildung 8 und Abbildung 9).

3.2 Chancen

- Vertrauen und Akzeptanz: Vertrauen und die Akzeptanz von KI-Systeme bei Nutzern und Stakeholdern verbessern.

- Risikominderung und Compliance: Erfüllung regulatorischer Anforderungen, z.B. EU KI VO.

- Verbesserung der Modellqualität: Zwingt zur genauen Überprüfung und Optimierung der KI-Modelle, was zu robusteren und präziseren Systemen führen kann.

- Förderung der Zusammenarbeit: Kommunikation und Zusammenarbeit zwischen Data Scientists, Entscheidungsträgern und Endnutzern verbessern.

- Innovations- und Wettbewerbsvorteile: Verbesserte Kundenbeziehungen, effizientere interne Prozesse und Erfüllung ethischer sowie gesellschaftlicher Erwartungen führen zu Wettbewerbsvorteil.

4 Zusammenfassung und Ausblick

4.1 Zusammenfassung

- Black Box KI Modelle führen zu diskriminierenden Entscheidungen, XAI notwendig für faire KI.

- XAI steigert Transparenz und Verständlichkeit von KI-Entscheidungen, adressiert “Black Box”-Problem.

- EU KI-Verordnung etabliert risikobasierte KI-Regulierung, fordert Transparenz für Hochrisiko-KI.

- Herausforderungen umfassen komplexe Erklärungen, fehlende Standards, Datenschutzbedenken.

- Chancen durch XAI: Verbessert Vertrauen/Akzeptanz, unterstützt Compliance, fördert ethische KI-Entwicklung.

4.2 Ausblick

- Entwicklung standardisierter Frameworks und Metriken zur Bewertung der Wirksamkeit und Qualität von Erklärungen

- Anpassung von Erklärungen an die Bedürfnisse und das Verständnisniveau des jeweiligen Nutzers

- Entwicklung interaktiver XAI-Tools, die es den Nutzern ermöglichen, Fragen zu stellen und zusätzliche Informationen zu den Entscheidungen der KI zu erfragen

- Entwicklung von Methoden, die Robustheit gegenüber Angriffen bzw. Manipulation ihrer Erklärungen gewährleisten (vgl. Biecek und Samek 2024), z.B.

- Ausnutzung von Unschärfebereichen in Erklärungsmodellen

- Täuschung durch plausible, aber falsche Erklärungen

- Erzeugung von Konflikten zwischen Erklärung und Entscheidung

4.3 XAI Beispiel für Manipulation

Abbildung 11: Beispiel für die Manipulation von XAI im Falle von Bilderkennung, Quelle: Baniecki und Biecek (2024)

Literatur

(X)AI Potentiale – Navigate, 12. März 2024 – Prof. Dr. Michael Bücker